|

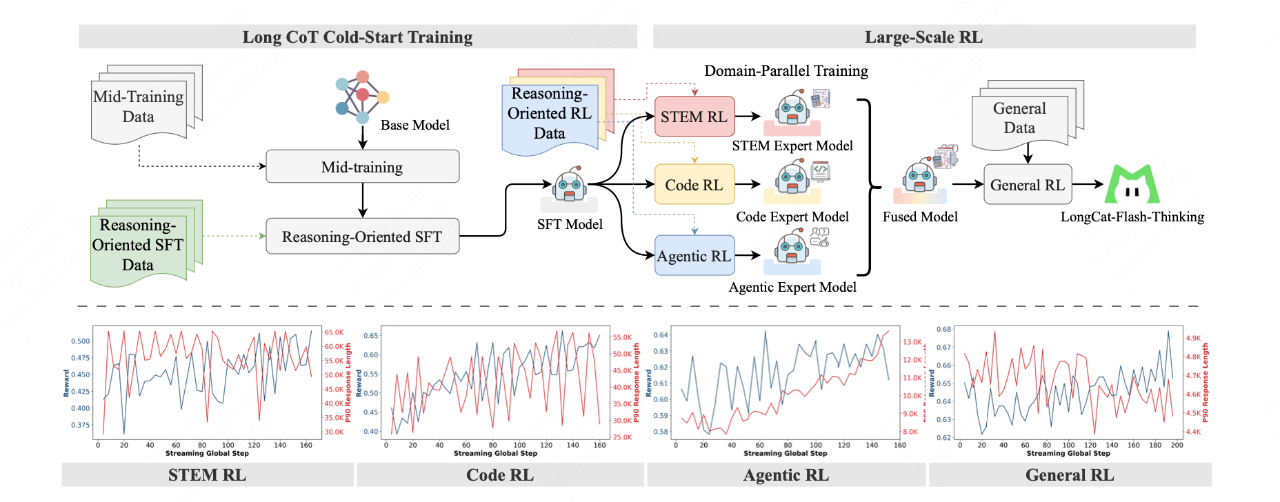

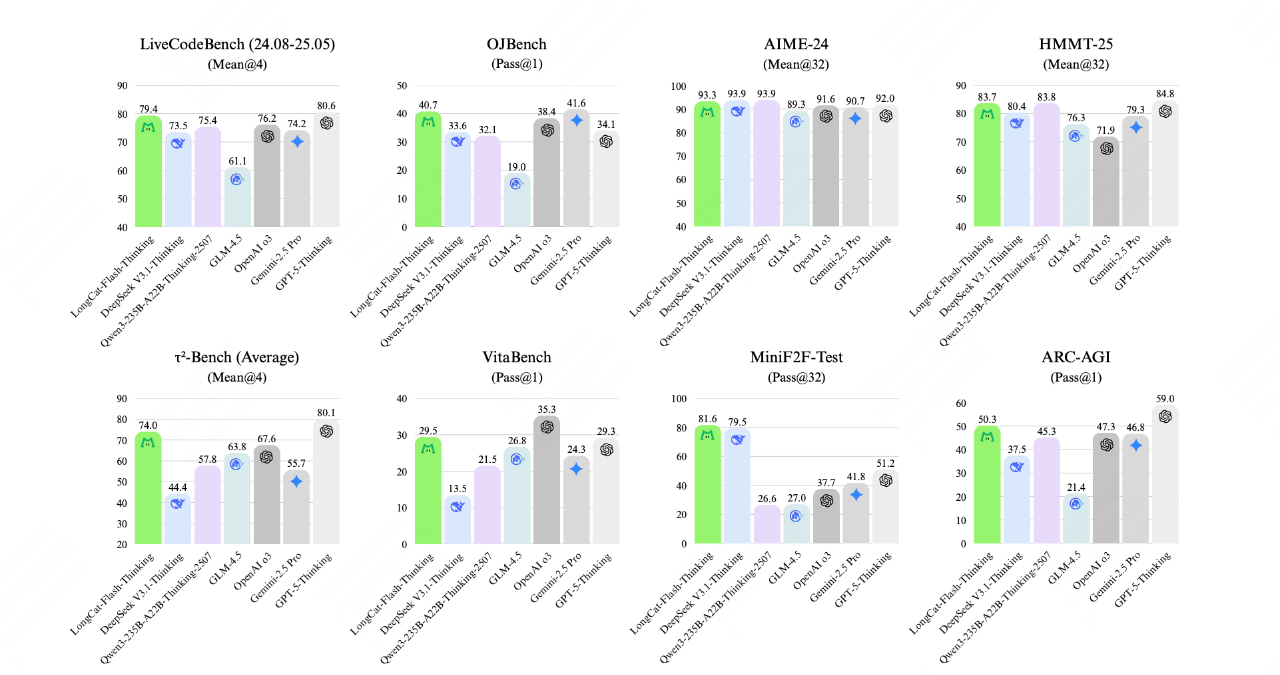

9月22日,美团(03690.HK)旗下龙猫LongCat团队宣布开源高效推理模型LongCat-Flash-Thinking。目前,该模型已在HuggingFace、Github全面开源。 这是继9月1日发布5600亿参数模型LongCat-Flash-Chat后,美团在AI大模型领域的又一新动作。 LongCat-Flash-Thinking是美团基于LongCat-Flash-Chat的升级版本,在保持极致推理速度的同时,显著提升了逻辑、数学、代码及智能体任务的性能,并在多个领域的推理任务中,达到全球开源模型SOTA(State of the Art,领域内先进水平)。 美团称,LongCat-Flash-Thinking不仅增强了智能体自主调用工具的能力,还扩展了形式化定理证明能力,成为国内首个同时具备“深度思考+工具调用”与“非形式化+形式化”推理能力相结合的大语言模型。 该模型采用领域并行强化学习训练方法(Domain-Parallel RL Training),通过多领域解耦优化策略实现帕累托最优(Pareto-Optimal),并依托异步弹性共卡系统(DORA)实现训练效率三倍提速。  基于AIME25实测数据,LongCat-Flash-Thinking在该框架下展现出更高效的智能体工具调用(Agentic Tool Use)能力,在确保90%准确率的前提下,相较于不使用工具调用节省了64.5%的Tokens(从19653到6965),显著优化了推理过程的资源利用率。 值得注意的是,在编程领域,LongCat-Flash-Thinking展现出开源模型SOTA与其综合实力。在LiveCodeBench上,以79.4分显著超越参与评估的开源模型,并与顶级闭源模型GPT-5表现相当;在OJBench基准测试中也以40.7的得分保持极强竞争力,并接近领先模型Gemini2.5-Pro的水平。  (文章来源:财中社) |

2025-10-31

2025-10-31

2025-10-31

2025-10-31

2025-10-31